Interview mit Prof. Dr. Harald Kittler, Leiter der Forschungsgruppe für bildgebende In-vivo-Diagnostik an der Universitätsklinik für Dermatologie der Medizinischen Universität Wien.

Digital Doctor: Herr Prof. Kittler, Sie sind Dermatologe und auf die Behandlung und Diagnostik bösartiger Hautveränderungen spezialisiert. Wie kam es dazu, dass Sie sich mit künstlicher Intelligenz beschäftigen?

Kittler: Ich habe gemeinsam mit meinem Kollegen Michael Binder (Anm.: Prof. Michael Binder, heute Ärztlicher Direktor des Wiener Gesundheitsverbunds) bereits vor 20 Jahren mit Methoden zur automatischen Klassifizierung von pigmentierten Hautläsionen experimentiert. Heute heißt das Machine Learning, damals hat das anders geheißen. Allerdings sind wir zu dieser Zeit in gewisser Hinsicht mit einem 2CV gefahren, und mittlerweile steht uns – und zwar allen – ein Formel-1-Motor zur Verfügung. Das macht natürlich Spaß und ermöglicht einen spielerischen Zugang, bei dem man einen Teil der Forschung unabhängig vom Labor zuhause vor dem Bildschirm erledigen kann. Hinzu kam, dass mir mit Philipp Tschandl ein junger Assistent zur Seite gestanden ist, der eine besondere Expertise in diesem Feld mitbrachte.

Digital Doctor: Was waren die ersten Forschungsfragen im Zusammenhang mit dem Einsatz von künstlicher Intelligenz, denen Sie nachgegangen sind?

Kittler: Wir beschäftigen uns mit der Diagnose von Hautkrebs, also einem sehr umschriebenen Gebiet der Medizin – quasi „einer kleinen Welt, in der die große ihre Probe hält“, um Friedrich Hebbel zu zitieren. Die dabei gewonnenen Erkenntnisse können meiner Ansicht nach auch auf zahlreiche andere Bereiche der Medizin angewandt werden. Die einfachste Fragestellung ist: Kann man mit dem Einsatz von maschinellem Lernen automatisierte Diagnosen auf Expertenniveau erstellen? Diese Frage ist in Hinblick auf Hautkrebs eindeutig mit einem Ja zu beantworten, ein Befund, der sich aber auch auf viele andere Bereiche der bildbasierten diagnostischen Medizin übertragen lässt, wie Radiologie, Ophthalmologie und zunehmend auch Pathologie.

Die zweite Frage, der wir nachgegangen sind, beschäftigt sich mit der Anwendung dieser Algorithmen in der klinischen Praxis. Wie hilfreich ist es, wenn Menschen so einen Support von Maschinen zur Verfügung gestellt bekommen? Wie wendet man das am besten in der Praxis an?

Digital Doctor: Zu welchen Ergebnissen ist Ihre Forschungsgruppe in diesem Zusammenhang gekommen?

Kittler: Zunächst ist mir wichtig, zu betonen, dass es eine grundsätzliche Diskrepanz zwischen dem AI-Hype und dem, was in der Praxis sichtbar ist, gibt. Mensch gegen Maschine bzw. Maschine statt Mensch ist sicher nicht das, was sich abspielen wird, weil Menschen einen ganz anderen Ansatz haben aufgrund ihrer Fähigkeit, ihren gesunden Menschenverstand einzusetzen. Egal, ob wir von selbstfahrenden Autos sprechen oder von Systemen zur Diagnoseunterstützung: Human Control ist wichtig, weil in der Praxis immer unvorhergesehene Dinge passieren können, für welche die Maschine nicht trainiert ist. Wir Menschen können in solchen Fällen unser generalisiertes Wissen einsetzen, die Maschine macht dumme Fehler. Der Schwerpunkt hat sich also von Human versus Computer zu Mensch in Kollaboration mit dem Computer verschoben. Mensch und Maschine ergänzen sich ganz eindeutig, aber die zentrale Frage muss lauten: Werden Menschen besser, wenn sie Maschinen verwenden?

Digital Doctor: Und wie lautet die Antwort?

Kittler: Sie fällt geteilt aus. Menschen werden durch den Einsatz von künstlicher Intelligenz in den meisten Fällen besser, sie werden aber schlechter, wenn die Maschine dumme Fehler macht. Dies ist dann der Fall, wenn die Maschine auf bestimmte Situationen nicht gut trainiert ist, wenn sie zum Beispiel in der Muttermaldiagnostik für einen hellen Hauttyp trainiert ist und plötzlich einen dunklen Hauttyp befunden soll. Dann kann es sein, dass die Maschine Unsinn produziert. Und was macht der Mensch, der diesem Unsinn ausgesetzt ist? Er macht auch dumme Fehler, weil er dem „Kastl“ zu sehr vertraut. Diese Neigung ist übrigens selbst bei Expert:innen festzustellen.

Digital Doctor: Das klingt, als müsste man nicht nur die Maschinen, sondern auch die Menschen neu trainieren.

Kittler: Genau – es geht um kontinuierliches Lernen der Maschinen und um kontinuierliches Lernen der Menschen, wie sie mit den Maschinen umgehen sollen. Derzeit haben wir das Dilemma, dass Anfänger:innen bzw. weniger erfahrene Dermatolog:innen am meisten profitieren. Es braucht aber Expertenwissen, um die Maschine risikofrei einzusetzen. Die, die also wirklich profitieren würden, haben nicht das nötige Wissen, um risikofrei damit umzugehen. Expert:innen wiederum sind zunehmend Mangelware, viele von ihnen gehen ins Ausland.

„Die Asymmetrie von Entscheidungen immer mit zu beurteilen – das ist ein grundlegender menschlicher Wert.“

Digital Doctor: Ist in diesem Zusammenhang auch Ihre aktuelle Studie* zu sehen? Als Versuch, das Dilemma auf der Seite der Maschine zu lösen?

Kittler: Wir haben tatsächlich versucht, die Maschine zu optimieren, wobei das ganze maschinelle Lernen im Grunde eine einzige Optimierungsaufgabe ist. Die Frage lautet, was ist die beste Gleichung, um das Gutartige vom Bösartigen zu unterscheiden? Als Arzt muss ich ja ständig Entscheidungen treffen, die auf einem individuellen Abwägen der Vor- und Nachteile für die Patient:innen beruhen. Bei dieser Gewichtung spielt sowohl der zeitliche Horizont eine Rolle – bei einem 17-Jährigen spielt ein ungewünschtes Ereignis, das innerhalb eines Jahres auftritt, eine andere Rolle als eines, das erst in 20 Jahren auftritt – als auch die Bedeutung des Outcomes für den/die Betroffene:n. In unserem Fall ist zum Beispiel die Frage ganz zentral, wie viele Entfernungen von gutartigen Läsionen nimmt man in Kauf, um eine bösartige zu entdecken. Diese Asymmetrie beurteilen wir Ärzt:innen immer mit – das ist ein grundlegender menschlicher Wert.

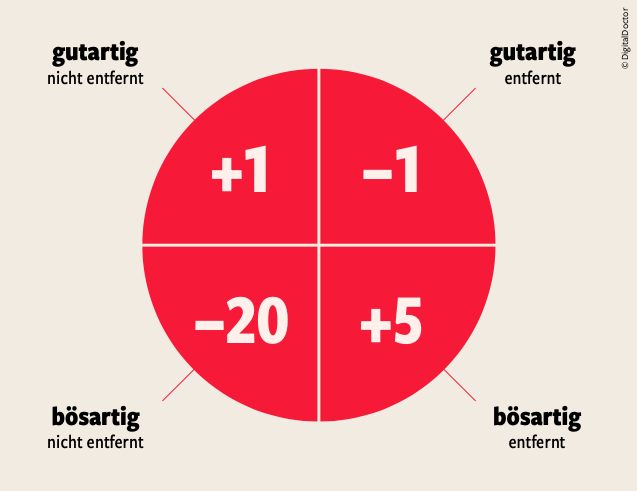

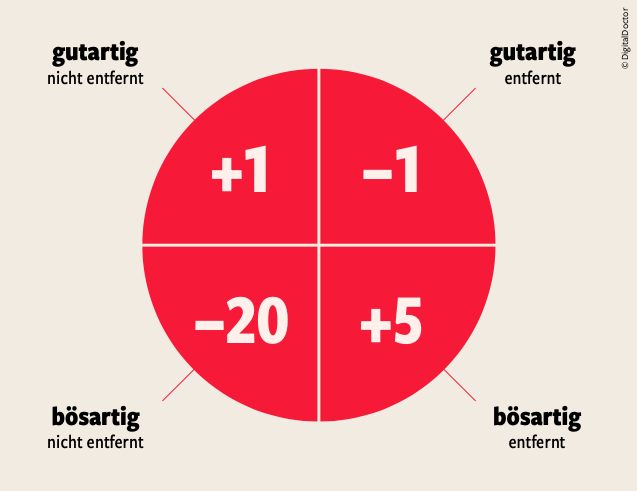

Reinforced Learning in der Hautkrebsdiagnostik: beispielhafte Belohnungstabelle

Digital Doctor: Sie haben die Maschine also nicht nur auf den Prozentsatz der richtigen Diagnose optimiert, sondern diesen menschlichen Wert miteinfließen lassen. Wie haben Sie das konkret umgesetzt?

Kittler: Mit einer Variante des sogenannten „reinforcement learning“(Verstärkungslernen), also einer Form des maschinellen Lernens, bei dem der Algorithmus für richtige oder falsche Entscheidungen belohnt oder bestraft wird. Das Programm lernt direkt aus den Folgen seiner Entscheidungen. Wir haben das umgesetzt, indem wir sogenannte Belohnungstabellen integriert haben. Was potenziell bösartige Hautläsionen betrifft, gibt es in der einfachsten Darstellung ja vier mögliche Szenarien, die ich vier Feldern einer Tabelle zuordnen kann (Abbildung). Szenario 1: Eine gutartige Läsion wird nicht entfernt. Szenario 2: Eine gutartige Läsion wird entfernt. Szenario 3: Eine bösartige Läsion wird nicht entfernt. Und schließlich Szenario 4: Eine bösartige Läsion wird entfernt. Wir sind uns wohl einig, dass es zwei wünschenswerte Szenarien gibt, nämlich 1 und 4. Nun geht es darum, die Tabelle zu kalibrieren. Wenn etwa eine gutartige Läsion entfernt wird, gibt es –1 Strafpunkte, wenn eine bösartige entfernt wird, bedeutet das +5 Belohnungspunkte, bei Nichtentfernen einer gutartigen Läsion +1 Punkt und bei Nichtentfernen einer bösartigen Läsion –20 Strafpunkte. Diese Gewichtung hängt natürlich auch vom/von der Patient:in ab. Ein:e eher ängstliche:r Patient:in wird die Entfernung einer gutartigen Läsion möglicherweise weniger negativ bewerten. Es geht also darum, den individuellen Sweetspot zu finden, was meist auf implizite Art zwischen Ärzt:in und Patient:in passiert. Wir wollten das in den Algorithmus integrieren und den Prozess gleichzeitig transparent machen.

Digital Doctor: Wie hat sich diese Belohnungstabelle nun auf die Zuverlässigkeit der Diagnostik ausgewirkt?

Kittler: Die Sensitivität für bösartige Diagnosen hat sich verbessert. Die Maschine hütet sich davor, bösartige Läsionen nicht als solche auszuweisen, weil das stärker bestraft wird – sie wird in ihrer Prognose unsicherer, was durchaus positiv zu bewerten ist.

„Der Arzt der Zukunft sitzt zwischen Maschine und Patient – als Interpreter, Übersetzer und Anwalt des Patienten.“

Digital Doctor: Wieso ist Unsicherheit in diesem Fall gut?

Kittler: Weil sie ein Ausdruck dessen ist, dass die Konsequenzen der Diagnosen in die Entscheidung miteinfließen. Supervidierte Maschinen, die über klassisches Feedback trainiert wurden, neigen nämlich zu Überkonfidenz, also 99% gutartig oder 99% bösartig. Reinforcement Learning, wie wir es angewandt haben, führt eher zu 70/30- oder 60/40-Aussagen. Der große Vorteil dabei ist, dass die Anwender:innen nicht mit falscher Gewissheit in die Irre geführt werden. Letztlich führt diese Methode zu einer höheren Sicherheit für die Patient:innen und zu einem besseren Support für die Anwender:innen der künstlichen Intelligenz.

Digital Doctor: Welchen Einfluss hat das nun auf die Rollenverteilung zwischen Ärzt:in und Maschine?

Kittler: Die Ärzt:innen müssen die Patient:innen auf die Maschine vorbereiten, weil diese so eine Belohnungstabelle schwer eigenständig generieren könnte. Der/Die Ärzt:in sitzt also zwischen Maschine und Patient:in, als Interpreter, Übersetzer:in und Anwält:in des/der Patient:in. Er erklärt dem/der Patient:in, was das Ergebnis, zu dem die Maschine kommt, bedeutet.

Digital Doctor: Brauchen wir also in Zukunft andere Ärzt:innen– weniger Merkweltmeister:innen und mehr empathische Kommunikationstalente?

Kittler: Ganz eindeutig. Wie wir die Ärzt:innen auswählen, sollte in Zukunft anders erfolgen. Wenn Wissen auf Tastendruck abrufbar ist, braucht es keine Grade A Students mehr – eine gewisse Grundintelligenz natürlich vorausgesetzt. Vor allem sollten jene ärztlichen Berufe, die derzeit quasi unsichtbar sind, wie Radiolog:innen und Patholog:innen, ihre Rolle überdenken und wieder auf die Patient:innen zugehen.

Digital Doctor: Abschließend noch eine Frage zu sogenannten Large Language Modellen wie ChatGPT. Welche Rolle könnten diese aus Ihrer Sicht in der Medizin spielen?

Kittler: Wenn man solche Modelle verwendet, staunt man, wie klug die Antworten teilweise sind, die sie geben. So ein generalisiertes Tool in der Medizin, das zuverlässige Antworten gibt, ist natürlich der Heilige Gral, an dem derzeit vor allem die großen IT-Unternehmen arbeiten. Wer weiß, vielleicht werden wir eines Tages aufwachen, und es wird einen ChatGPT für Medizin geben, und wir werden „Aaah“ sagen.

Digital Doctor: Vielen Dank für das Gespräch!